Обработка научных данных

Современную научную статью невозможно представить без статистического анализа данных и математического обоснования выводов. Исследователь, который действительно хочет найти верные ответы на поставленные вопросы, должен иметь общее представление об алгоритмах получения, обработки и представления данных. Наука о данных (data science) – более широкое понятие, которое включает в себя все компоненты обработки данных: получение и подготовку данных к анализу (очистка), статистическую обработку, разработку программного обеспечения и решение поставленных задач на основе полученных результатов. Основой (но не эквивалентом) data science являются базы данных (архитектура и администрирование), работа с «большими данными» (big data engineering), машинное обучение или высокоточные расчеты. Суть науки о данных не лежит в плоскости специализированных баз данных или языков программирования, даже если они незаменимы для практического применения. Основу науки о данных составляет взаимодействие между содержанием данных, цели конкретного проекта и методы анализа данных, используемые для достижения этих целей. Специалист по анализу данных, конечно, должен управлять всем этим массивом с помощью соответствующих программ, но что это за программы и как их применять – это уже детали.

Цель создания этих методических материалов – не пытаться охватить все существующие методы обработки информации, а дать общее представление об алгоритме сбора и обработки биомедицинских данных. Существует множество подходов к анализу данных, поэтому приведенная информация может отличаться сведений, которые вы можете почерпнуть в других источниках. Приведенные сведения отражают личное мнение автора на основании опыта, полученного на протяжении нескольких лет научной работы в области медицины, сбора и обработки данных.

Структура базы данных исследователя

Одно из первых действий, которое выполняет новоиспеченный аспирант, соискатель или исследователь – создание базы данных для сохранения получаемой информации. Приведу несколько основных принципов сбора данных для научного исследования.

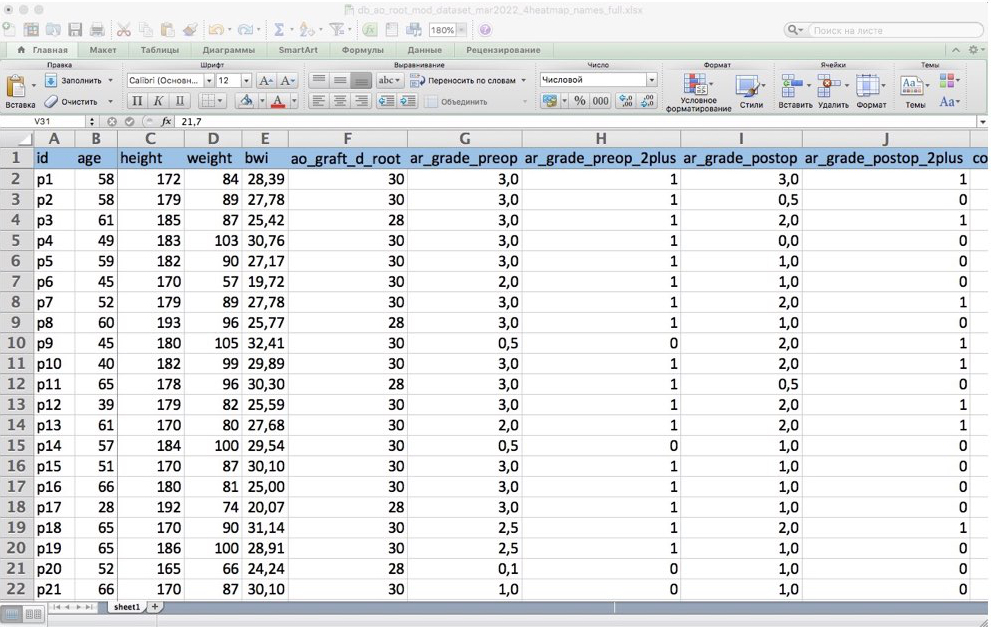

- Чем проще, тем лучше. Если у исследователя нет опыта работы со специализированным программным обеспечением (многочисленные виды SQL и NoSQL баз данных, элементы пакетов офисных программ вроде Microsoft Access, Open Office Base), не стоит в начале работы дополнительно усложнять себе жизнь – на этом этапе не так важен механизм реализации базы данных, как ее структура и наполнение, и наибольшее значение имеет выбор адекватных признаков для максимально подробной характеристики исследуемой выборки. Лучше отдать предпочтение несложным электронным таблицам (Excel от Microsoft, Open Office Calc, Numbers от Apple). Еще одно преимущество простой электронной таблицы – легкий экспорт данных в другие программы и форматы.

- Никаких многоуровневых и объединенных или разделенных ячеек. Проверенный метод серьезно усложнить себе жизнь – построить таблицу сложной структуры, а если там еще будут скрытые строки, то вы точно потратите больше времени на поиск данных в своей базе и их подготовку для анализа, чем на саму статистическую обработку. Единственная таблица в Excel на одном листе – идеальная база данных.

- Только цифры и латиница. Не используйте кириллические шрифты – неизвестно, какими методами и программами вы будет обрабатывать свои данные, да и неожиданные программные ошибки не исключены. Старайтесь минимизировать использование текста, применяя его только для комментариев, от которых невозможно отказаться. В идеале база данных должна содержать текст только в названиях столбцов и обозначениях случаев (cases), а все остальное представлено только в виде цифровых и бинарных значений (0 или 1, что обычно соответствует «нет» или «да»).

- Анонимизируйте исследуемых людей. В первом или втором столбце обычно указывают первичный ключ – уникальное обозначение каждого случая (пациента). Универсальным требованием является полная анонимизация пациентов. Удобным методом обозначения пациентов в базе данных является использование их инициалов и даты рождения. Например, Петров Иван Николаевич, родившийся 19 сентября 1968 года может обозначаться как pin190968 или pin19091968.

- Заранее продумайте конечные точки. Конечные точки – события, которые исследователь рассматривает как значимые и достоверно характеризующие проводимый эксперимент (исследование). Обычно в исследованиях с участием когорт людей (пациентов) в качестве первичной конечной точки рассматривается неблагоприятный исход либо свобода от неблагоприятного исхода в течение периода наблюдения. Вторичными конечными точками обозначают различные неблагоприятные события, или осложнения. Например, во многих исследованиях в области кардиологии и сердечно-сосудистой хирургии фигурируют так называемые «большие неблагоприятные сердечно-сосудистые и церебральные события» (Major Adverse Cardiovascular and Cerebral Events – MACCE): инфаркт миокарда, острое нарушение мозгового кровообращение, острая ишемия какой-либо зоны, острое расслоение и/или разрыв аорты, повторная операция на каком-либо отделе сердечно-сосудистой системы.

- Указывайте даты наступления всех событий и конечных точек. Упоминание о проведении исследования, любое событие (например, применительно к исследованиям в области медицины, раннее или позднее осложнение операции) должно сопровождаться указанием даты. Само собой, наступление или ненаступление события обозначается «1» или «0». С помощью встроенных формул вы рассчитаете временные интервалы, а когда в процессе анализа данных будете рассчитывать свободу от наступления этих событий по методу Каплана-Майера – вспомните себя добрым словом.

- Осмотрительно используйте встроенные формулы и специальные возможности. Это удобные вещи, но при изменении структуры таблицы или переносе данных из ячеек с результатами вычислений можно столкнуться с искажением или потерей части данных.

- Резервное копирование данных. Максимально обязательная вещь – создание копий своих данных. Рекомендую использовать как постоянное резервное копирование «на лету», так и создание копий с определенной периодичностью. Можно использовать любой облачный сервис (Dropbox, Яндекс Диск, Google Drive), отдельную флеш-карту или внешний накопитель данных. Подавляющее большинство публичных облачных сервисов имеют бесплатные планы использования с лимитом не менее 5 ГБ. Также почти все подобные сервисы интегрируются в файловую систему таким образом, что когда вы сохраняете файл на своем компьютере, данные автоматически копируются в облако, и последняя версия файла доступна на любом другом привязанном устройстве.

Часть исследовательской базы данных в Microsoft Excel

Определение объема выборки

Вы построили структуру своей базы данных, обозначили исследуемые признаки, и далее требуется эту базу заполнить. На этом этапе для дальнейших корректных статистических расчетов важно определить необходимое и достаточное число случаев (пациентов), которые будут включены в исследование. Определение соответствующего размера выборки для исследования, независимо от его типа, является фундаментальным аспектом биомедицинских исследований. Большинство исследователей чаще сталкивается с недостатком, чем с переизбытком материала для исследования, и даже при вроде бы большом объеме материала при публикации статьи и подготовке доклада обязательным будет привести математическое доказательство, что статистические расчеты на основании выбранной группы корректны. Адекватная выборка гарантирует, что исследование даст достоверную информацию, независимо от того, будут ли данные в итоге свидетельствовать о клинически значимой разнице между изучаемыми вмешательствами или элементами.

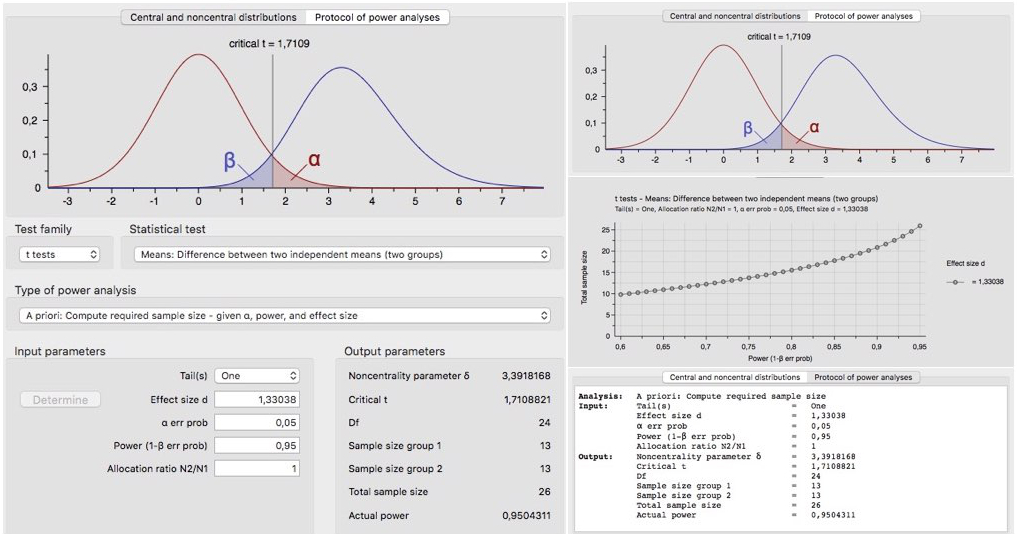

Возможны два типа ложных выводов, называемых ошибками 1 и 2 рода, вероятность которых обозначается символами σ и β. Ошибка 1 рода возникает, когда делается вывод о наличии различий между сравниваемыми группами, хотя на самом деле их нет (ложноположительный результат). Ошибка 2 рода возникает, когда делается вывод о том, что различий не существует, в то время как в действительности различия существуют, и они равны или больше размера эффекта, определенного альтернативой нулевой гипотезе (ложноотрицательный результат). При рассмотрении риска ошибки второго типа более интуитивно понятным является представление о мощности исследования, или (1 – β). Мощностью обозначается вероятность обнаружения различия, если разница между сравниваемыми группами действительно существует. Меньшее значение α или большая мощность увеличивают объем выборки. Обычно при расчете объема выборки приемлемые значения мощности и α составляют, соответственно, 80% или выше и 5% или ниже. Размер эффекта – наименьшее клинически значимое различие, которое предполагается обнаружить, и для обнаружения меньших различий требуются более крупные выборки. Хотя эти принципы давно известны, исторически определение размера выборки было трудным из-за относительно сложных математических соображений и множества различных формул. В последнее время значительно улучшилась доступность, возможности и удобство использования программного обеспечения для определения мощности и размера выборки. Программа Stata позволяет анализировать размер выборки, необходимый для сравнения средних и пропорций, анализа распространенности. Большее число опций предлагают специализированные пакеты nQuery Advisor и UnifyPow. Весьма простым в использовании является бесплатный калькулятор G*Power.

Расчет необходимого объема выборки с помощью калькулятора G*Power

Программы для статистической обработки данных

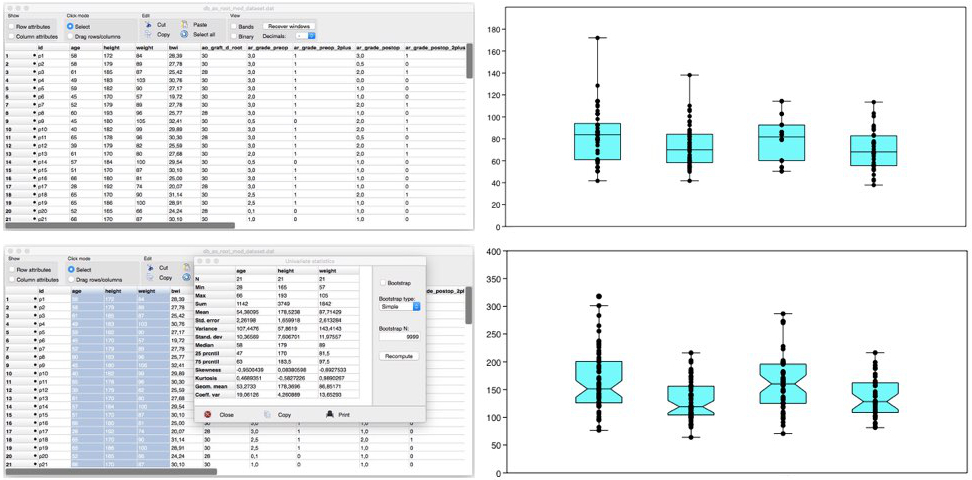

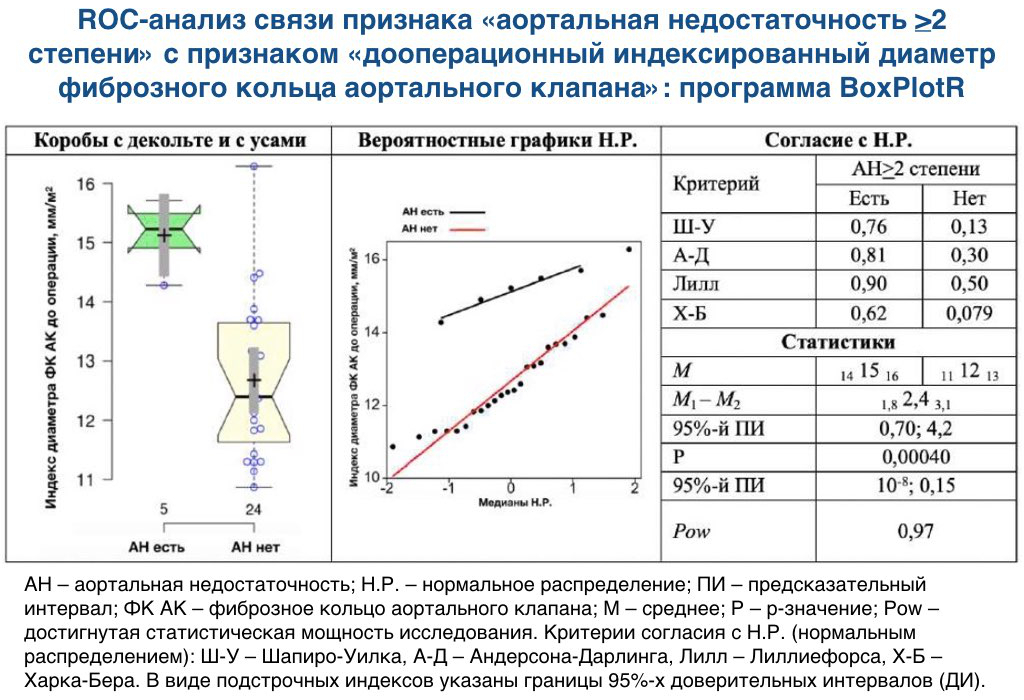

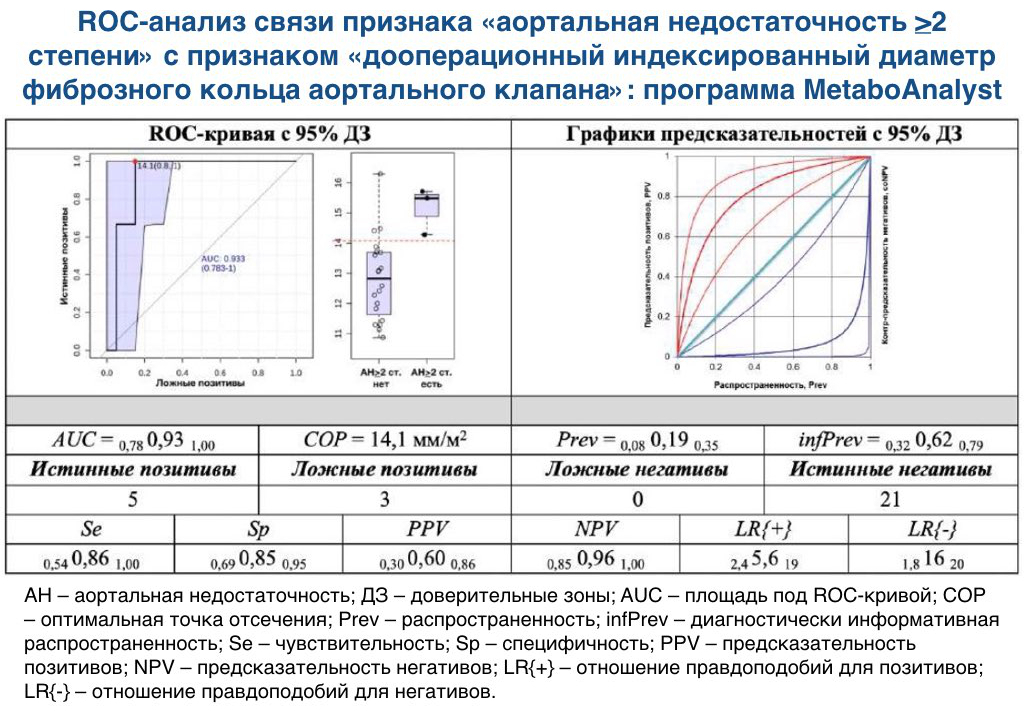

Поздравляю, вы создали и заполнили базу данных – это 70% успеха в биомедицинских исследованиях. Наступает приятный момент работы с данными и поиска новых закономерностей, возможно, вы даже сделаете научное открытие (но это неточно). На этапе статистической обработки данных вы также можете пользоваться различными программными продуктами. Существует великое множество программ для статистической обработки, универсальных и специализированных, бесплатных и платных, работающих оффлайн и онлайн. К известным, универсальным и платным (и весьма недешевым) относятся мощные программные пакеты SPSS(IBM) и Statistica (StatSoft). Бесплатным аналогом с урезанным функционалом SPSS является программа PSPP. Очень хорошей мощной универсальной и бесплатной альтернативой является программа PAST. При решении специальных задач (например, для ROC-анализа, построения специальных графиков и диаграмм, работы с данными метаболомики) можно воспользоваться сервисами easyROC, BoxPlotR, MetaboAnalyst.

Использование программы PAST 3.0 для анализа данных и построения диаграмм

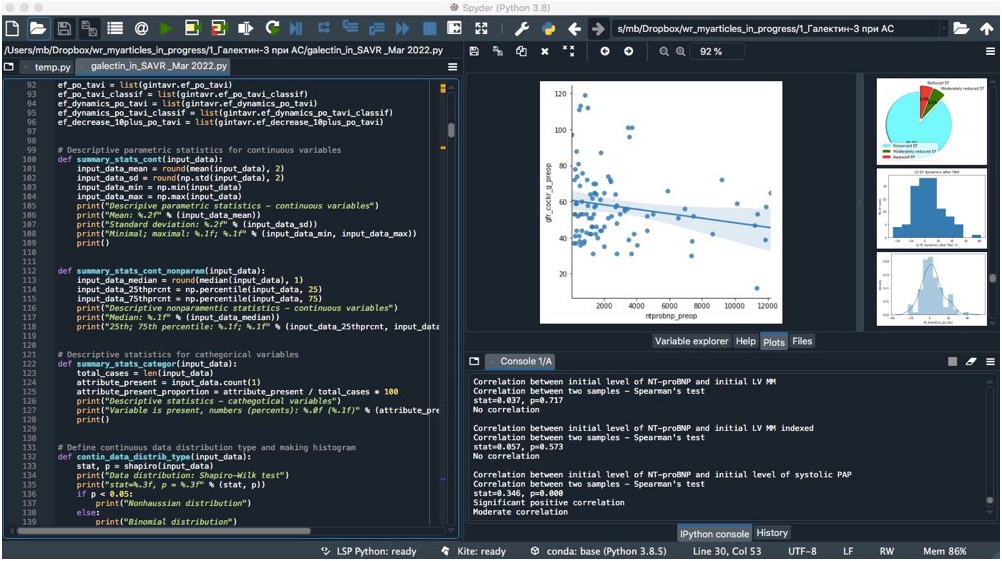

Польза изучения языков программирования. В последнее время для анализа данных биомедицинских исследований все чаще применяются среды разработки с открытым исходным кодом, например, RStudio, SPYDER (Scientific PYthon Development EnviRonment) или Jupyter Notebook (в том числе как часть среды разработки Anaconda). Они требуют знания языков программирования (Python, R) и ряда соответствующих библиотек (при анализе данных с помощью языка Python наиболее часто применяются библиотеки Pandas, NumPy, SciPy, Seaborn) для статистической обработки и визуализации. Освоение этих инструментов может быть непростым и небыстрым, однако они весьма мощны, максимально универсальны, самодостаточны и, что немаловажно, абсолютно бесплатны.

Использование среды разработки SPYDER 4.1.5 и языка программирования Python 3.8 для анализа данных и построения диаграмм

Типы и распределения данных

Для корректного представления и обработки данных исследователь должен правильно выделять их разные типы: непрерывные (принимающие любое значение), дискретные (принимающие только целочисленные значения) и категориальные, которые могут принимать только определенный набор значений (категорий). Частным случаем категориальных являются бинарные (двоичные) данные, принимающие только 2 категории значений: «1» и «0» («истина» и «ложь»). Порядковыми обозначают категориальные данные с отчетливо выраженной упорядоченностью.

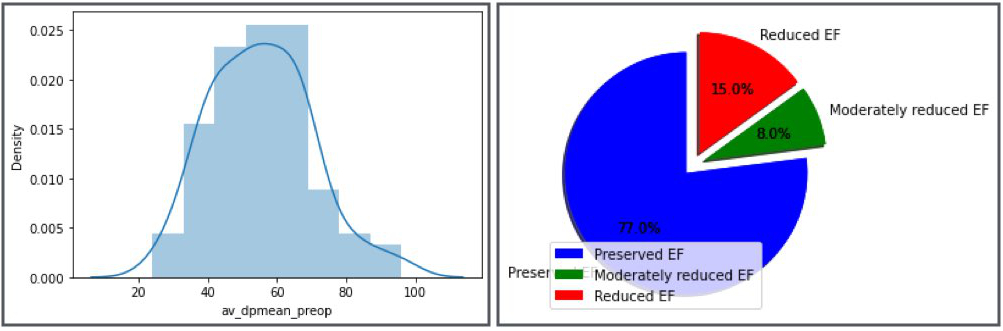

До начала любого анализа необходимо определить тип распределения данных каждого исследуемого признака, и в зависимости от распределения исследователь выбирает подходящие методы статистической обработки. Если распределение данных нормальное (68% данных находятся в пределах одного стандартного отклонения от среднего, 95% – в пределах двух стандартных отклонений, и 99,7% – в пределах трех стандартных отклонений, что более характерно для крупных групп), для статистического анализа возможно использование параметрических критериев. В целом, если число пациентов 30 и менее, обычно используют непараметрические методы анализа данных. Даже если пациентов больше, то, как правило, в биомедицинских исследованиях данные распределены ненормально, и для более точных расчетов рекомендуется использовать непараметрические методы. Для статистического анализа дискретных данных (определенные события, произошедшие за определенное время) можно использовать другие типы распределений, например, распределение Пуассона. Для оценки нормальности распределения данных обычно используются критерии Шапиро-Уилка, Андерсона-Дарлинга, Колмогорова-Смирнова, Лиллиефорса, Харка-Бера. Для максимальной наглядности для каждого признака имеет смысл строить график распределения данных, и при автоматизации проверки всех переменных на нормальность распределения (например, при использовании сред разработки SPYDER и Jupyter Notebook) построение графиков не отнимает дополнительного времени.

Гистограмма распределения непрерывных данных и круговая диаграмма распределения дискретных данных

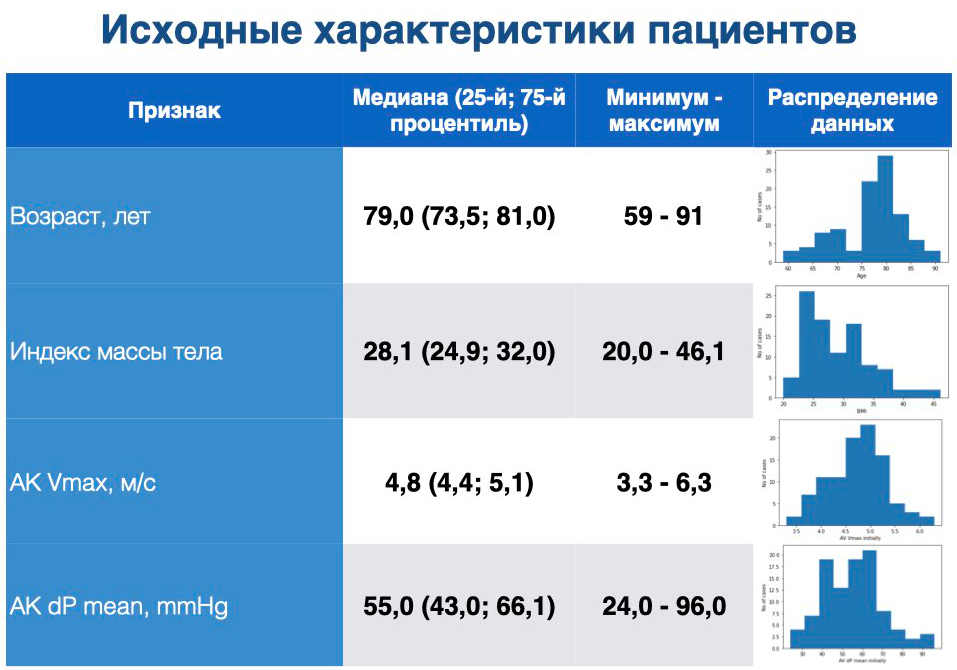

Общие характеристики данных

Для каждой исследуемой переменной рассчитываются общие статистические характеристики (summary statistics). Непрерывные нормально распределенные данные обычно представляются в виде среднего (М – сумма всех значений, деленная на их число) и стандартного отклонения (SD – квадратный корень из дисперсии). В случае ненормально распределенных данных более правильно приводить значения медианы (Me – значение 50-го процентиля, то есть число, расположенное ровно посередине в списке значений, отсортированных от меньшего к большему) и 25-го и 75-го процентилей. В отличие от среднего, медиана не подвергается влиянию выбросов – значений, далеко удаленных от других значений. Размахом обозначают разницу между самым малым и самым большим значениями, которые принимает признак. Интерквартильный размах (разница между 75-м и 25-м процентилями) не так информативен, поэтому в большинстве случаев я рекомендую воздерживаться от его использования. Категориальные данные обычно представляются в виде единиц и процентов (долей). Характеристиками категориальных данных также являются мода (наиболее часто встречающееся значение) и математическое ожидание (среднее значение на основе вероятности появления категории). Доверительный интервал – интервал, который покрывает неизвестный параметр с заданной надежностью. Например, 90% доверительный интервал окружает 90% распределения определенного признака. Граничные точки доверительного интервала обозначаются как доверительные пределы. Доверительный интервал отражает вариабельность результата выборки. С уменьшением объема выборки растет уровень неопределенности и, соответственно, увеличивается доверительный интервал. Для интервальных статистических оценок используется компактная и наглядная форма их представления, при которой нижняя и верхняя границы доверительных интервалов указываются слева и справа от точечной оценки в виде подстрочных индексов. Важным компонентом хорошей научной работы является уместная визуализация данных – в таблицу возможно поместить максимальный объем данных, но хороший график всегда будет информативнее. Общепринятыми способами визуализации данных являются коробчатые диаграммы, частотные таблицы, гистограммы, графики плотности данных, столбчатые и круговые диаграммы.

Представление общих характеристик данных в презентации

Связанные и несвязанные группы

После расчетов общих статистических характеристик данных исследователь начинает оценивать значимость различий и/или изменения групп. С учетом вида распределения данных и в зависимости от типа групп (зависимые или независимые) выбирается наиболее адекватный статистический метод. Независимые (несвязанные) группы объединяют данные, которые набирались в них независимо друг от друга, например, характеристики двух групп пациентов, которые параллельно получают разные лекарственные препараты. Зависимые (связанные) группы – одна и та же группа, в которой одни и те же признаки претерпевают определенные изменения на протяжении наблюдения. Примером являются параметры эхокардиографии у одной и той же группы пациентов в течение периода наблюдения на фоне назначения определенного лечения.

Значимость различий между группами

Параметрические методы анализа правильно характеризуют только нормально распределенные данные, а в ситуации ненормального распределения будут получены неверные результаты. При анализе ненормально распределенных данных, в особенности в малых группах, решением является использование непараметрических критериев, когда реальные значения переменных заменяются рангами. Соответственно, при нормально распределенных данных значимость различий между независимыми группами обычно оценивается с помощью дисперсионного анализа и критерия Cтьюдента; в случае зависимых выборок применяется критерий Стьюдента для зависимых групп и дисперсионный анализ для повторных измерений. В условиях ненормально распределенных непрерывных данных значимость различий оценивается с помощью непараметрического U-критерия Манна-Уитни (для несвязанных групп) и непараметрического критерия Вилкоксона (для связанных выборок). Значимость различий между тремя и более группами ненормально распределенных данных оценивается при помощи непараметрического критерия Краскела-Уоллиса. В случае дискретных данных значимость различий между несвязанными группами оценивается при помощи критерия хи-квадрат, при анализе связанных групп – с применением критериев МакНемара и Кокрена.

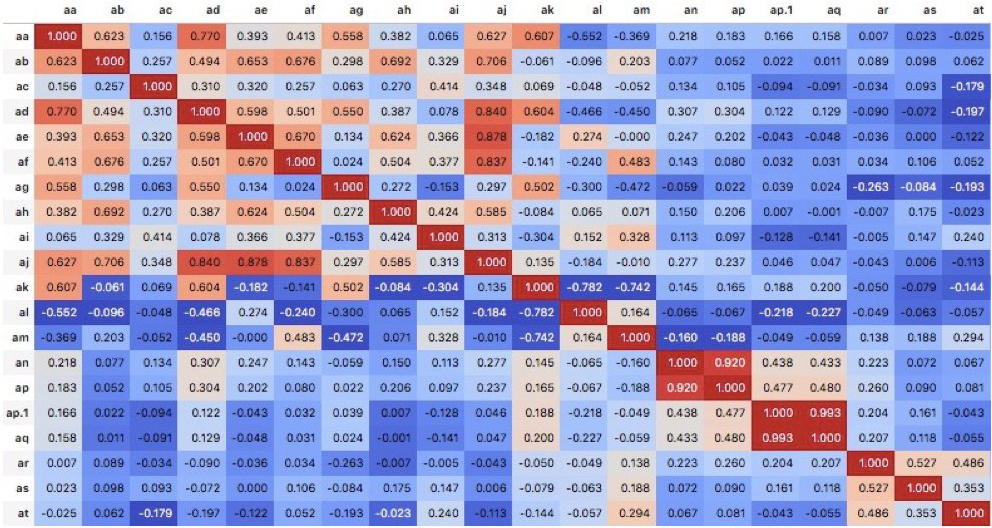

Корреляция

Корреляция – связь между двумя признаками, когда высокие значения одного из них сопровождаются высокими (положительная корреляция) или низкими (отрицательная корреляция) значениями другого. Для исследования связей между признаками проводится корреляционный анализ с расчетом коэффициента ранговой корреляции Спирмена (для ненормального распределения) или Пирсона (в случае нормально распределенных данных). Обычно степень корреляции оценивается как выраженная при значении коэффициента корреляции больше 0,66, как умеренная – от 0,33 до 0,66, и незначительная – при значении коэффициента корреляции менее 0,33. Визуально корреляционные зависимости между переменными представляются в виде таблицы (корреляционной матрицы), в которой переменные размещены в строках и столбцах, а корреляции между переменными представлены в ячейках. Модифицированным вариантом корреляционной матрицы является «тепловая карта» корреляций (heat map), когда «теплый» или «холодный» цвет обозначают положительную или отрицательную корреляцию, а яркость – выраженность корреляционной зависимости.

Тепловая карта корреляций (heat map), среда разработки Jupyter Notebook

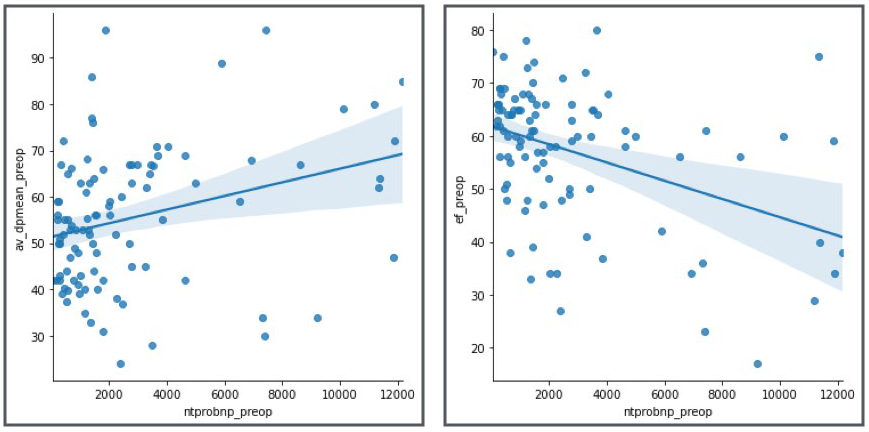

Регрессия

Регрессия («возвращение назад») – метод статистического моделирования, когда оценивается линейная связь между одной или несколькими переменными предсказания (предикторные переменные) и переменной исхода (выходная переменная). Разница между корреляцией и регрессией заключается в том, что корреляция измеряет выраженность связи между переменными, а регрессия дает количественную оценку природе этой связи. При простом линейном регрессионном анализе оценивается, насколько изменится переменная В (response, или отклик, зависимая переменная, значение которой исследователь пытается предсказать) при изменении переменной А (independent variable, или предиктор, независимая переменная, применяемая для предсказания отклика) на определенную величину. Логистическая регрессия аналогична линейной регрессии, за исключением того, что предсказывается бинарная переменная исхода («1» или «0», «да» или «нет»).

Графики простых линейных регрессионных зависимостей

Предсказательное моделирование, ROC-анализ и другие методы

Более углубленным методом статистического анализа является предсказательное моделирование с построением матрицы несоответствий – таблицы, в которой приведены правильные и неправильные предсказания, объединенные по типу отклика в категории. Здесь связанными терминами являются точность (доля случаев, которые правильно классифицированы), чувствительность (доля правильно классифицированных единиц), специфичность (доля правильно классифицированных нулей) и прецизионность (доля предсказанных единиц, которые на самом деле оказались нулями). Граничные значения переменных, оказывающих значимое влияние на события, могут оцениваться при помощи построении ROC-кривой. ROC (receiver operating characteristics)-кривая представляет собой график чувствительности против специфичности. AUC (area under curve) – общая площадь под ROC-кривой, и чем она больше, тем точнее классификация. Выживаемость и свобода от наступления определенных событий определяется с помощью метода Каплана-Майера. Для выявления наиболее значимых признаков и оценки их влияния может использоваться анализ главных компонент. Другими методами статистического машинного обучения являются древовидные модели (деревья решений) и метод К ближайших соседей.

ROC-анализ для поиска граничных значений переменных, влияющих на события

Заключение

Специалист в своей области, владеющий даже ограниченным арсеналом методов статистической обработки данных, выполнит анализ данных лучше и может обнаружить больше важных связей и зависимостей, чем профессиональный статистик, не являющийся специалистом в определенном разделе науки. Уверенность в полученных выводах основывается на определении гипотезы (первым этапом) и проведении эксперимента для ее проверки (вторым этапом), что происходит далеко не всегда. Нередко исследователь начинает работать с уже имеющимися данными, пытаясь найти закономерности, и в такой ситуации не всегда можно сказать, реален ли полученный вывод, или он представляет собой продукт подробной ревизии данных. Необходимо взвешенно подходить к построению эксперимента, отбору и анализу данных – если данные «мучить» достаточно долго, они сдадутся, и будет получен результат, далеко не всегда верный. С погружением в работу у исследователя будут возникать вопросы все более конкретного характера, ответы на которые можно найти в специализированных ресурсах и источниках, приведенных в разделе «Полезные ресурсы». Кроме того, всю новую информацию о написании научных статей, data science, статической обработке, визуализации данных, бесплатных руководствах и многое другое я выкладываю в своем телеграм-канале.